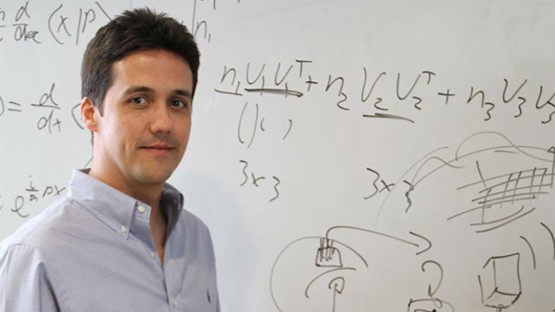

- Catedrático de Ingeniería Electrónica y Neurociencia por la prestigiosa Universidad de California-Berkeley, es pionero en el desarrollo de interfaces cerebro-máquina

- «Una persona con una discapacidad motora podrá aprender a mover un brazo robótico solo con el pensamiento»

- Carmena participará en las IV Jornadas Neurocientíficas y Educativas de la Fundación Querer

José Carmena es Catedrático de Ingeniería Electrónica aplicada a la Neurociencia por la prestigiosa Universidad de California-Berkeley, donde ha trabajado durante casi dos décadas como profesor e investigador. Además, Carmena es pionero en el desarrollo de interfaces cerebro-máquina -tecnologías que permiten la comunicación directa entre el cerebro y un dispositivo externo, como un brazo robótico o una prótesis-, para restaurar la función motora en personas con discapacidad.

En 2017, creó la empresa de biotecnología iota Biosciences, con el objetivo de transformar la investigación en un producto con impacto real en la sociedad. Asimismo, también forma parte del equipo que asesorará en la creación del Centro Nacional de Neurotecnología ‘Spain Neurotech’, centro que pretende convertirse en referencia mundial de la aplicación de la inteligencia artificial a la neurotecnología.

Carmena viajará de California a Madrid este mes para participar en las IV Jornadas Neurocientíficas y Educativas que organiza la Fundación Querer, donde compartirá su amplio conocimiento sobre las interfaces cerebro-máquina y sus aplicaciones en enfermedades del sistema motor y será galardonado con el premio ‘Hero Award Internacional’ por su prestigiosa trayectoria internacional en el cambio de la Ingeniería Electrónica y la Neurociencia.

Pregunta: Enhorabuena por este reconocimiento. ¿Qué supone para usted ser galardonado con el ‘Hero Award Internacional’ de la Fundación Querer?

Respuesta: Es un inmenso honor, fue algo totalmente inesperado. Voy a las jornadas con mucha ilusión porque conozco a otros ponentes y siempre es grato reunirte con colegas y gente a la que admiras. Y, sobre todo, porque me parece muy interesante todo lo que conozco sobre la Fundación Querer, su visión y metas.

P: En su ponencia hablará sobre las interfaces cerebro-máquina y sus aplicaciones en enfermedades del sistema motor, un campo en el que está especializado. ¿Por qué decidió dedicarse a investigar en este sector?

R: Porque satisfacía mis dos motivaciones principales. Por un lado, la vocacional -derivada de tener una familia de médicos-, de hacer algo con aplicación clínica para gente con discapacidad. Es decir, poner la tecnología al servicio de la sociedad. Y la otra, puramente científica, mi pasión por investigar sobre cómo funciona el cerebro. En este caso, utilizando la tecnología interfaz cerebro-máquina como paradigma experimental.

«La interfaz cerebro-máquina puede mejorar la calidad de vida de muchísimas personas con enfermedades motoras, sensoriales y cognitivas»

P: Para aquel que desconozca de qué trata. ¿Cómo funciona una interfaz cerebro-máquina?

R: Primero tenemos una tecnología implantada (invasiva) o no implantada (no invasiva) en el cerebro encargada de registrar la actividad neuronal. La no invasiva se realiza con tecnología de electroencefalograma (EEG), electrodos que se colocan en el cuero cabelludo, y la invasiva consiste en hacer una craneotomía del cráneo e insertar en la corteza cerebral unos electrodos. Esto, por supuesto, no genera dolor dentro del cerebro.

Después, un algoritmo matemático traduce las señales de las neuronas en señales motoras de control de un robot para realizar una determinada tarea. Por ejemplo, mover un brazo robótico para alcanzar un vaso de agua solo con el pensamiento. La idea es que el paciente que no puede mover su brazo, pero tenga su cerebro intacto, aprenda a mover un brazo robótico solo con pensar en cómo quiere hacerlo.

P: Este proceso requerirá mucho entrenamiento…

R: Sí, hay una parte muy importante que es el feedback. En este caso, el más directo y simple es el visual. El paciente está viendo cómo de bien o mal está haciendo la tarea. Al ver el error que comete el cerebro lo puede utilizar para, en el siguiente intento, corregir ese error y hacerlo mejor. Con el tiempo se observa que el paciente va mejorando. Esto nos permite estudiar la plasticidad neuronal y cómo el paciente aprende a controlar el brazo robótico cada vez mejor. Llega un momento en el que aprende y es experto en controlarlo.

P: La interfaz cerebro-máquina es un sistema con el que el cerebro puede ‘controlar’ un robot, pero ¿también puede ‘sentir’ a la máquina?

R: Sí, un avance es incluir la sensación táctil para mejorar el control. Es decir, además de poder mover ese brazo robótico, sentir lo que la mano robótica está agarrando y así poder hacer un agarre más preciso, al tener más incorporado ese cuerpo que no es natural. De esta forma, si por ejemplo voy a darle la mano a alguien sería importante que pudiera sentir esas sensaciones táctiles para no apretar demasiado fuerte. Es muy importante hacer tanto la decodificación como la codificación de esas sensaciones táctiles artificiales de vuelta al cerebro.

P: ¿La interfaz cerebro-máquina permite controlar otro tipo de sistema, además de brazos o piernas robóticas?

R: Otra tarea que se realiza mucho es controlar un cursor mirando una pantalla de ordenador y hacer tareas con ese cursor como, por ejemplo, escribir o dibujar. Eso lo puedes hacer con el pensamiento. Hay muchos estudios que lo han demostrado, tanto en monos como en pacientes humanos.

«Podrías hablar con Siri literalmente con el pensamiento, sin tener que hablar y de forma mucho más rápida»

P: ¿A qué tipo de personas con discapacidad podría ayudar esta tecnología y cómo?

R: Puede mejorar la calidad de vida de muchísimas personas con discapacidad motora. Y no solo ayuda en enfermedades motoras, sino también sensoriales y cognitivas. Hasta en el habla. Lo último que ha salido hace unos meses es utilizar esta tecnología con la actividad motora de querer hablar cuando la persona no puede hacerlo. Utilizando mucha inteligencia artificial, se puede decodificar con mucha fidelidad las señales musculares de lo que el paciente quiere decir, solo con el pensamiento. Es decir, podrías hablar con Siri literalmente con el pensamiento, sin tener que hablar y de forma mucho más rápida. Hay compañías que ya están trabajando en técnicas no invasivas para esto, no solo para personas con discapacidad. Por otro lado, hay compañías que se dedican a utilizar las interfaces cerebro-máquina en implantes como prótesis de memoria para la gente que tiene problemas de memoria consecuencia de un ictus, por ejemplo.

P: ¿Qué aplicaciones tendría para personas sin discapacidad?

R: Aparte de restaurar enfermedades sensoriales, motoras o cognitivas, también puede aumentar ciertas funciones. Hoy en día, por ejemplo, ya hay prótesis para gente con amputaciones de pierna que no les dejan competir con atletas normales porque corren más rápido que ellos ya que pueden alcanzar unas velocidades espectaculares, más potentes que las que las piernas naturales. También, aunque no le veo una utilidad ahora, tener una prótesis visual que te estimula la corteza visual de forma que entrenas a tu cerebro a ver también el espectro infrarrojo. O en el tema de la memoria, por ejemplo, poder almacenar muchísimas más cosas en el cerebro de las que podemos. Estas dos últimas son ciencia ficción aún, pero el camino de la neurotecnología va hacia allá.

P: ¿Cuáles son los mayores desafíos a los que os enfrentáis los investigadores en el desarrollo y aplicación de este tipo de interfaces cerebro-máquina?

R: Un problema importantísimo y que se discute mucho ahora es la ética de las neurotecnologías, conocida como «neuroética». Los problemas éticos, por ejemplo, para gente sin discapacidad de usar tecnologías por el efecto de desigualdad que puede producir en la sociedad al crear dos clases distintas, la gente aumentada y la que no lo está. Después, en personas con discapacidad puede haber problemas de protección de datos. Si solo el avance de la inteligencia artificial ya es un problema, por el poder que tiene esa tecnología, si encima la combinas con implantes neuronales en el cerebro, todo se amplifica.

P: Fundó en 2017 la empresa de biotecnología iota Biosciences. ¿Qué tipo de dispositivos desarrollan?

R: Estamos centrados en la parte de neurotecnología, lo que son los sensores o estimuladores para el cerebro o cualquier parte del cuerpo. Por ejemplo, sensores para medir el oxígeno en la sangre, la temperatura, el ph, la presión sanguínea o cualquier parámetro en un órgano; o para estimular la actividad eléctrica en un nervio en el cuerpo. Es el campo de lo que se llama bioelectromedicina y que es más global que solo la interfaz cerebro-máquina para control motor de un robot. Aquí estamos hablando de conectar todas las autopistas de información que van por tu cuerpo, desde el cerebro a tus extremidades, por todo el sistema nervioso, hasta un órgano.

P: Toda esta tecnología, si hablamos en particular de las interfaces cerebro-máquina, tiene un coste elevado. ¿Cómo se está trabajando para garantizar que sea accesible para todas las personas?

R: Ahora mismo, esta tecnología existe mayoritariamente en el ámbito clínico, donde se espera que el seguro médico te lo cubra, igual que cuando se hace una operación de trasplante de hígado o un implante de estimulación eléctrica para el párkinson. Son cosas muy caras que la Seguridad Social o el seguro que tenga cada uno está pensado que cubra o cubra mayoritariamente. Ese es el modelo de financiación en principio. Y ya, si se trata de cuestiones de aumentar capacidades, habrá algunas que sean más caras y que no te cubra el seguro porque sea simplemente un «capricho», pero eso es un problema ético que está por ver y discutir porque está ahí.